Listamos os equívocos mais vistos no dia-a-dia do trabalho de análise de dados, tanto do ponto de vista técnico quanto conceitual – e que devem ser evitados para respaldar um bom trabalho. Há também os charlatães dos dados, que não sabem ou querem enganar com suas análises para benefício próprio e acabam prejudicando todo o processo da área.

Lidar com dados e seus processos, tanto técnicos quanto de negócios, é um trabalho complexo, minucioso e que exige bastante conhecimento, prática e cuidado para que sejam considerados dignos de respeito – e de embasar decisões importantes das organizações. Alguns cuidados são importantes durante a manipulação dos dados e em sua análise e aqui listamos alguns erros comuns que podem acontecer no dia-a-dia – mas que devem ser evitados a todo custo.

Konstantina Vasileva, analista de dados e pesquisadora STEM da Nova Zelândia, aponta uma lista com os erros técnicos mais comuns de serem cometidos:

Ter uma hipótese mal definida

É fundamental construir uma imagem clara das previsões de resultados correspondentes a diferentes teorias. Quais são as suposições? Qual é a hipótese? Como se encaixam nas teorias existentes? Se a hipótese não for definida com clareza, haverá dificuldade em analisar e interpretar os resultados futuros.

Deixar os vieses afetarem a análise de dados

Com uma hipótese clara com suposições bem definidas, é preciso traçar uma linha entre ter clareza conceitual e permitir que o viés pessoal afete a análise. Questões como relatórios de resultados seletivos, confirmação e viés de seleção, viés de outlier e o Paradoxo de Simpson são algumas das tantas armadilhas que podem sem encontradas pelo caminho, deixando que a intuição e o preconceito conduzam os dados, em vez de os dados serem o fio-condutor.

Inferindo Causalidade de Correlação

Ao encontrar correlação entre variáveis, será tentador supor que uma delas causa a outra. No entanto, existem inúmeras pontos a serem levadas em consideração: tanto A quanto B podem ser consequências de um terceiro fator C, mas não podem ter nada a ver um com o outro; A pode estar causando C, que é a causa de B (ou vice-versa), pode ser direta (A causa B), reversa (B causa A), causalidade cíclica (A causa B e B causa A, por sua vez) ou mesmo a correlação completamente coincidente, sem qualquer conexão entre A e B.

Tylor Vigen, no blog Spurious Correlations, apresenta conjuntos de dados hilários que não são relacionados, alguns dos quais exibem níveis impressionantes de correlação próximos de 100%:

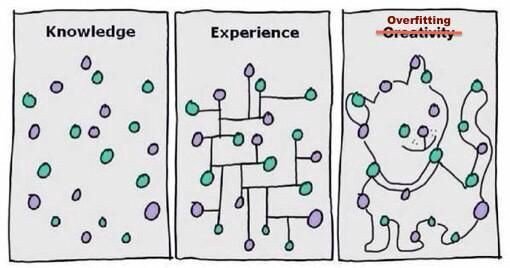

Overfitting Data

Em uma situação ideal é possível treinar um modelo com dados existentes e aplicá-lo a outro conjunto de dados com distribuição semelhante para fazer previsões.

Um erro comum seria fazer um modelo muito complexo que está tentando ajustar um conjunto limitado de pontos de dados a uma extensão tão estreita que, em vez de “eliminar” o ruído, você o inclui no modelo.

Como resultado, o modelo exibirá excelente desempenho quando você o aplicar ao conjunto de dados inicial, mas seria extremamente inadequado quando se trata de previsões sobre novos dados.

Underfitting Data

Underfitting é o inverso do último: um modelo que tem baixo valor preditivo porque perde parâmetros que deveria ter incluído. Em outras palavras, o espaço de hipóteses explorado pelo algoritmo de aprendizagem é muito pequeno para representar os dados. Assim, o modelo é altamente enviesado e incapaz de inferir conhecimento válido a partir dos dados de treinamento inicial.

Erros Tipo 1 (Falsos Positivos) e Tipo 2 (Falsos Negativos)

Em estatísticas e pesquisas científicas, há uma declaração padrão geral chamada de hipótese nula H0, por exemplo: “não há relação entre exercícios regulares e melhor aptidão cardiovrespiratória, medida em VO2 máx”, que se busca rejeitar para confirmar a hipótese alternativa H1. É como “o exercício regular aumenta o VO2 máx e, portanto, melhora a aptidão cardiorrespiratória”.

Erros do tipo 1 ocorrem quando se rejeita incorretamente a hipótese nula, como um “alarme falso”, também conhecido como falso positivo.

Por outro lado, se falhar em rejeitar uma hipótese nula que é de fato errada, se comete um erro tipo 2, ou falso negativo. Por exemplo: um ensaio clínico que não detectou uma condição existente.

Além das armadilhas técnicas existentes na análise de dados, existem diversos pontos a serem observados conceitualmente, como tomadas de decisões e o planejamento do processo. Confira alguns:

Deixar o modelo de dados ficar obsoleto

Se temos um modelo de dados que funciona bem para um problema, podemos pensar em continuar usando-o, mas os modelos precisam ser atualizados e será preciso construir modelos adicionais com o passar do tempo, uma vez que a empresa, o mercado, os concorrentes, os clientes não são estáticos. Eles são dinâmicos e os modelos precisam ser assertivos acompanhando as mudanças.

Não testar o novo modelo em grupos de controle

Sem um grupo de controle para testes, não será possível medir quanto o modelo realmente funciona. É importante um programa de gerenciamento de mudanças para garantir que o modelo seja adotado e um grupo de controle que não o está usando. A dica é ter um grupo aleatório buscando oportunidades identificadas pelo modelo e um grupo de controle “buscando as coisas da maneira que sempre foram feitas”.

Automatizar sem monitorar o resultado final

Não ter um grupo de controle também interfere em rastrear melhorias ao longo dos processos, levando o modelo a ser otimizado para o objetivo errado. Por exemplo, se uma empresa começa a utilizar um bot em seu serviço telefônico e não verifica continuamente se a tecnologia está levando a uma maior satisfação do cliente, o único ponto positivo é utilizar menos mão de obra, mas não significa que o objetivo foi alcançado. Se os clientes estão fechando os casos de suporte porque o bot não consegue dar a resposta certa, e não porque resolveu o problema, a satisfação do cliente vai cair.

Cassie Korzykov, Head of Decision Intelligence no Google, fala sobre os charlatães de dados, os profissionais que não sabem ou que querem enganar com suas análises de dados para benefício próprio e acabam prejudicando todo o processo da área.

“Os charlatães de dados são tão bons em se esconder à vista de todos que você pode até ser um sem perceber”, provoca a executiva.

Ela destaca que bons analistas de dados são modelos de mente aberta e, ao contrário dos charlatões, não tiram conclusões além de seus dados.

Os analistas dizem: “Essa é a rainha de ouros que você acabou de jogar”.

Os estatísticos dizem: “Eu escrevi minhas hipóteses neste pedaço de papel antes de começarmos. Vamos brincar, observar alguns dados e ver se estou certo”.

Os charlatães dizem: “Eu sabia que você ia jogar aquela rainha de ouro o tempo todo, porque…“

(O aprendizado de máquina diz: “Vou continuar ligando com antecedência e vendo como me saí, continuamente, e eu posso adaptar minha reação a uma estratégia que funcione. Mas vou fazer isso com um algoritmo, porque controlar tudo manualmente é chato”).

Em resumo, Cassie entende que os bons analistas oferecem inspiração de mente aberta, os estatísticos oferecem testes rigorosos e os charlatões oferecem uma visão retrospectiva distorcida que fingem ser análises mais estatísticas.